人工智能企业要组建道德委员会,该怎么做?

发布时间:2019-07-30 00:25来源: 网络整理2019年7月24日下午,中央深改委召开第九次会议,审议通过《国家科技伦理委员会组建方案》。这表明国家对构建科技伦理治理体系前所未有的高度重视,而人工智能伦理是科技伦理中重要的内容。

在此背景下,我国人工智能企业成立伦理委员会正当其时。但人工智能企业怎么组建伦理委员会也成为一大现实难题。昨天我们发文讨论了组建国家科技伦理委员会释放了什么信号?今天,新京报智慧城市研究院特别刊登中国人民大学法学院副教授,未来法治研究院社会责任和治理研究中心主任郭锐、中国人民大学法学硕士李依及刘雅洁的深度长文,为企业和大众进一步解答人工智能企业的伦理委员会应当如何组成。

文 |郭锐、李依、刘雅洁

人工智能技术的开发和应用深刻地改变着人类的生活,渗透交通出行、金融科技、教育培训、资讯平台等方方面面。日益广阔的应用场景,让一个共识逐渐明晰:人工智能对伦理秩序冲击的深度和广度,可能是任何现代科技都难以比拟的。而掌握最前沿技术、担负着技术落地执行者角色的科技公司们,尤其应该有明确的伦理意识,并将对伦理的考量贯穿始终。这其中尤为重要的方式之一便是设立伦理委员会。

AI伦理委员会在实践中有多种称谓,常见的有“伦理道德委员会”“伦理审查委员会”“伦理风险委员会”等。而设置伦理委员会的目的,从这些大同小异的名称中也可见一斑:一是让AI伦理“成为问题”:让合伦理性在AI产品开发的诸多考量因素中占据一席之地;二是让AI伦理的审查尽可能专业、独立:与其让一线研发人员在技术和伦理的不同标准中无所适从,不如将伦理部分剥离出来,交由专门机构集中应对。

许多科技公司面临的一个困境是,尽管算法歧视等AI伦理风险普遍存在,但程序员缺乏对伦理进行准确判断的专业知识,也难以承担诸如“自动驾驶汽车应优先保护车内乘客还是车外行人”等关键伦理选择的责任。因此,相对独立集中且成员具备多元背景的伦理委员会,更适于对这些伦理问题进行判断。

其实,这一尝试在国外早已有之。目前、Google、Lucid AI、微软等多家大型科技公司已经设立了伦理审查委员会。审查委员会一般由具有不同知识背景和经验的专家组成,在审查时参考一定的行业标准,并最大限度地考虑安全和伦理问题。如微软成立了“伦理道德委员会”,由产品开发、研究员、法律事务、人力资源等部门的负责人组成。[1]

伦理委员会应当具备哪些职能?

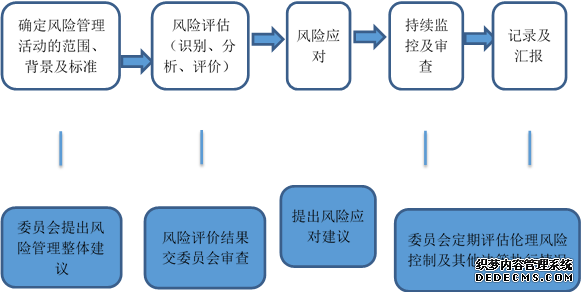

从机构定位上看,伦理风险管理委员会应当作为伦理风险管理的领导机构,组成人员可以包括主要人工智能研发部门的负责人、企业法务和/或合规部负责人以及处理伦理风险问题的协调专员。主要职能可以包括制定企业内部伦理风险管理政策、对伦理风险管理的相关问题做出决策、进行算法审计及质量审查工作以及协调企业内部各部门的伦理风险应对工作。

尤应注意的是,伦理委员会并不是企业在构建AI伦理风险治理机制时唯一依赖的机构,企业不能奢望将所有伦理问题委由伦理委员会一揽子解决,而不提供配套的执行机制。从委员会的性质上看,成员将主要负责评估和风险决策的制定,但难以作为执行机构将具体决定落到实处。

因此,伦理委员会可领导整个风险管理流程的实施及监督,并交由各业务部门的具体伦理风险管理小组具体实施相关决策,并定期将成果汇报至伦理委员会。

一般意义上的AI风险管理流程(白底框)和人工智能伦理委员会职能(蓝底框)的对应关系大致如下图所示:

具体而言,企业内部设立的人工智能伦理委员会应当具备如下职能:

1. 领导AI伦理风险控制流程的实施及监督。此外,为管理人工智能可能产生的伦理风险,委员会可以建立相应的内部制度对风险进行识别、评估、处理、监控及汇报,以管理相关风险。对于伦理风险的管理应从人工智能产品或服务的设计阶段开始,并贯穿于产品或服务的整个生命周期。

2. 参与AI的伦理风险评估。委员会可以定期进行伦理风险评估,对企业总体可能涉及的伦理风险进行识别,评估一段时间内相关伦理风险应对措施是否适当且有效。委员会可以根据相关法律法规以及政府及行业标准的规定,具体评估本企业所面临的风险,并记录评估内容及结果。还可以视情况聘请外部专家参与评估,确保评估的有效性。